検索エンジンの歴史とSEOの変遷

Contents

- 1 検索エンジンの歴史とSEOの変遷

検索エンジンの歴史とSEOの変遷

この記事では、検索エンジンの歴史とそれに対するSEOの変遷を書いています。

今のSEOを学ぶためには過去の歴史を学ぶことが不可欠です。

歴史を学ぶことで、今後の検索エンジンの進化が予測できるので、それに合わせて、今からやらなければならないSEO対策を知るきっかけになれば幸いです。

検索エンジンとは?

検索エンジン(けんさくエンジン、search engine)は、狭義にはインターネットに存在する情報(ウェブページ、ウェブサイト、画像ファイル、PDFファイルなど)を検索するプログラムを言います。

広義には、インターネットに限定せず、情報を検索するシステム全般を含みます。

このページで取り上げるのはインターネット、とりわけWeb上に存在するWebページ、画像ファイル、動画ファイルなどのデータを検索する狭義の意味の検索エンジンです。

検索エンジンの問題点

Webの発達とともにWebサイトの数は爆発的に増えました。Webサイトの数が増えれば増えるほど検索対象になる情報の量が増えたので、インターネットユーザーが探している情報を見つけることが困難になりました。

この問題を解決するために、数多くの検索エンジンの開発が進められました。Webが誕生した時、検索エンジンは大きく分けて2種類ありました。1つは人間がWebサイトを編集するディレクトリ型検索エンジン。もう1つはクローラーと呼ばれるソフトウェアが自動的に情報を収集して編集するロボット型検索エンジンです。

ディレクトリ型検索エンジン

ディレクトリ型検索エンジンは、人間が人力で1つずつWebサイトの名前、紹介文、URL等をデータベースに登録してカテゴリ別に整理した検索エンジンです。情報を収集するのも、その内容を編集して整理するのも、編集者という人間の手によって行われていました。

ディレクトリ型検索エンジンの検索方法は2つあります。1つはカテゴリ検索です。Webサイトが多数のカテゴリに整理されて分類されているので、インターネットユーザーはカテゴリを絞り込んでいくことで、目的のWebサイトを発見することができます。大きなカテゴリーから小さなカテゴリーに絞り込んでいくという方法です。

もう1つはキーワード検索です。検索ウィンドウにキーワードを入れて検索することにより、あらかじめ登録されているウェブサイトの中からそのキーワードに一致するWEBサイトが検索結果に表示される仕組みです。

ディレクトリ型検索エンジンのメリット

- 登録サイトが人間によって管理されているため、無駄な情報が少なく有益な情報が整理された形で掲載されているので使いやすい。

- Webサイトをディレクトリ編集者が適切だと判断したカテゴリに登録するため、ユーザーは自分の興味のある分野に関するWebサイトをカテゴリを通して発見することができる。

- ディレクトリ編集者がWebサイトの内容をチェックして登録するため、内容が乏しいサイトや不適切なサイトが登録されないため、無益な情報は有害な情報が検索結果に表示されない。

ディレクトリ型検索エンジンのデメリット

- Webページ単位ではなく、Webサイト単位で登録されるため、登録サイトに目的の情報が存在したとしてもキーワード検索でヒットしない場合がある。

- Webサイト、Webページ数が急増した場合、人間の手によってサイト情報を登録・編集していくのは限界があるため情報量が少ない傾向がある。

- 編集者が登録するWebサイトを決定して説明文を記述するため、編集者の主観や運営会社の方針によって掲載される情報に偏りが出る場合がある。

ディレクトリ型検索エンジンとして最も成功したのがYahooです。

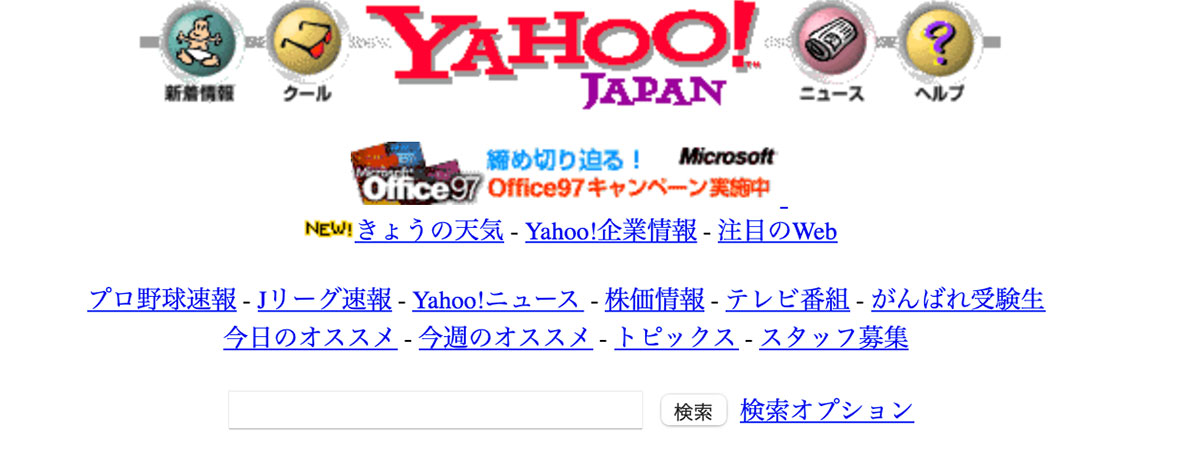

1997年のYahoo! JAPAN

Yahooカテゴリという膨大な数のカテゴリを要する日本最大のディレクトリ型検索エンジンでした。その後、ロボット型検索エンジンであるGoogleが登場して検索市場を席巻するまではYahooが非常に大きな力を持っていました。

ロボット型検索エンジンであるGoogleの対等により、Yahooカテゴリはその役割を終え、2018年3月にサービスを終了しました。また、業界2位だったクロスレコメンドが2019年2月に、業界第3位のクロスメディアディレクトリが2019年11月に相次いでサービス終了となりました。

これにより、国内の大手ディレクトリサービスは全て消滅しました。

ちなみに、当時、Yahooカテゴリに掲載してもらうためには、非商用サイトの場合は無料でしたが、商用サイトの場合にはビジネスエクスプレスと言って、一般サイトで5万円、特定ジャンルのサイトで15万円が必要でした。

非商用サイトの場合は無料ですが、登録されるための基準が非常に高く、よほど良いオリジナルのコンテンツが掲載されていないと登録されず、Yahooカテゴリに登録されるのはかなりハードルが高いものでした。

ロボット型検索エンジン

ロボット型検索エンジンは、クローラーと言われるソフトウェアをインターネット上に送り、クローラーがインターネット上に蜘蛛の巣のように張り巡らされているWebサイトを巡回し、情報を収集し、検索エンジンのデータベースに登録します。

ユーザーは、検索ウィンドウにキーワードを入力し、それにマッチしたWebサイトが検索結果に表示されます。

表示される検索結果の内容は、ロボットが独自のアルゴリズムで計算した結果です。

ロボット型検索エンジンのメリット

- Webサイトをサイト単位ではなくページ単位で登録するため、特定のキーワード検索にマッチしたWebページが確実に表示される。

- 定期的にクローラーがインターネットを巡回しているので、比較的新しいWebページも登録されている。

- 大量のクローラーがインターネット上を巡回し自動的に登録しているため、人間の手では対応できない大量のWebサイト、Webページの情報がデータベースに登録されている。

- クローラーが常にインターネット上を巡回しているため、Webページが更新された時に、新しい情報に書き換えるので、比較的新しい情報がデータベースに登録されている。

ロボット型検索エンジンのデメリット

- 無益なページや有害なページまで含めて大量の情報が登録されており、検索時に多数の情報が表示されるので、目的の情報を探すのが難しい場合がある。

- 自動的に情報が登録されるので、実際のページの内容とは関係のないキーワードを詰め込むなどのスパム行為が行われ、必要な情報が検索結果に表示されないことがある。

- ロボットが自動的に紹介文などを決定するため、人間の手による編集と比べると情報が不自然であったり整理されていないことがある。

ロボット型検索エンジンには、かつてこのようなデメリットがあったのですが、技術の進化によって、これらの問題はほぼ解消されており、今ではロボット型検索エンジンが主流になっています。

ロボット型検索エンジンが主流になっているので、ユーザーはWebサイトをページ単位で検索できるようになりました。これは検索結果に表示されるのがトップページとは限らず、サブページやカテゴリーページに検索エンジン経由で直接ランディングしてくる人が増えてくることを意味します。

ロボット型検索エンジンが主流になったことで、トップページだけではなく、全てのページの重要性が増しました。

Googleのアップデートの歴史

1990年代

Alta Vista、Infoseek、Yahooなどが誕生。

これらのいずれもがキーワードの詰め込みなどの検索エンジンスパムに対応できず、検索精度は低かった。

少し遅れて1997年にGoogle.comが登場。

PageRankという画期的な技術を取り入れたGoogleにより、極めて精度の高い検索結果が表示されるようになった。

2000年代初頭

Googleが台頭してくる時期。

2000年代初頭のGoogle.com

2003年11月

フロリダアップデート

個々のキーワードだけではなくウェブ全体を見るアプローチが採用されました。

ページタイトルやページの内容と関係のない、意味のない大量のキーワードを詰め込んだページがスパムと判定され順位を落としたアップデートです。

フロリダアップデート後は、検索結果で上位表示したい意味のない大量のキーワードを詰め込むことでGoogleにサイトの内容を誤認させる「キーワードスタッフィング」と呼ばれる手法を利用したブラックハットSEOの手法が通用しなくなりました。

2005年1月

nofollow属性の誕生

通常のリンクは、そのページが持っているリンクジュース(ページ評価)をリンク先ページに渡しますが、nofollow属性が付されているリンク先には、リンクジュースを渡しません。

リンクを売買した時や、掲示板、ブログのコメントなどのリンクにはnofollow属性を付けることが推奨されています。

これにより、通常の自然リンクとページランクを上げることだけを意図したスパム的なリンクを区別できるようになりました。

2005年6月

パーソナライズド検索を発表

パーソナライズド検索(Personalized Search)は、Googleの検索機能のひとつで、ユーザーの利便性を図るために、その人に合った検索結果をそれぞれにカスタマイズして自動でユーザーごとに異なる検索結果を表示する機能のことを言います。

例えば、ユーザーの所在地、キーワードの検索履歴、サイトやクリックしたリンクの履歴などを元にパーソナライズド検索の結果が表示されます。

2009年6月

Bingの登場

マイクロソフトが検索エンジンBingを発表しました。

Googleに対抗できる検索エンジンとして期待されましたが、Googleほどの検索精度がなく、Googleの牙城を崩すことはできませんでした。

今でもBingのシェアは伸びず7%くらいのシェアを推移しています。

2009年8月

カフェインを発表

クロールの高速化、インデックスの拡大、インデックスとランキングをリアルタイムで連携でき?ようになった。

Caffeineは、従来のインデックスと比較して検索結果のに表示される情報の鮮度が50%以上改善されたと言われている。

当時のデータ量にすると1日数十万ギガバイトの速度で新しい情報を追加していた。

カフェイン検索順位に大きな変動が生ずるアルゴリズムのアップデートではなく、インデックスシステムのアップデートである。

2010年から

2010年7月27日Yahoo! JAPANの検索エンジンにGoogleの検索エンジンが採用される

Googleの覇権が決定的になりグーグルが検索エンジンの市場シェアを独占する。

これにより国内のグーグルの検索エンジンの市場占有率が約90%を超えることになる。

2011年

パンダアップデート

Googleのアルゴリズムアップデートの中で、おそらく一二を争うくらい有名なアップデートで、日本では2012年頃に導入されました。

品質の低いコンテンツがスパムと判定され、順位を大きく落としたアップデートでした。

パンダアップデートを契機として多くのウェブマスターがコンテンツ重視のサイト運営方針に切り替えました。

パンダアップデートの前までは文章を細切れに分割して、それを組み替えて文章を自動で生成するというワードサラダというスパム行為が横行していたのですが、パンダアップデートによって、そのようなスパム行為がほとんど使われなくなりました。

パンダアップデートは、その後も逐一アナウンスはされていませんが、定期的にアップデートが実施されています。

2012年

パイレーツアップデート

パイレーツアップデートは、デジタルミレニアム法案(DMCA)に抵触する著作権侵害を行うホームページの評価を下げるためのアップデートです。

著作権を無視した運営を行う違法ホームページが増加したことから、それを取り締まるために、Googleはパイレーツアップデートアルゴリズムを導入しました。

ペンギンアップデート

検索順位を不正に上げることを目的に行われる、不自然な自作自演のバックリンクサイト群を構築するブラックハットSEOを取り締まることを主な目的としたアップデートです。

品質の低いサイトからの不自然な大量のバックリンク、特定のキーワードで上位表示するための不自然な大量のアンカーテキストなどが取り締まられました。

これにより、自作自演のバックリンク群を構築し、無理矢理上位表示されていたサイトの多くが順位を落としました。

このアルゴリズムを悪用して、ライバルサイトに大量の質の低いリンクを貼る事で、ライバルサイトの順位を落とす逆SEOも横行しました。

そこで、ペンギンアップデート4.0によって、スパム性のあるものに対する評価をマイナスではなく、単に「無視(無効化)」するようになり、逆SEOができなくなりました。

ペンギンアップデートにより、無料ブログなどからのバックリンクが効果を失ったことから、IPアドレスを分散した質の良い中古ドメインを使ったバックリンク群を構築するという手法が流行するようになりました。

2013年

ハミングバードアップデート

ハミングアップデートは、Googleが検索キーワードを単なる単語の羅列としてではなく、意味のある一連の文章として理解するようになったアップデートです。

ハミングアップデートの導入により、検索結果も単なる単語の羅列にマッチしたものではなく、文章の意味に対応したものが表示されるようになりました。

例えば、ハミングバード導入前のGoogleであれば、「ドラッグストア 近く」というキーワードで検索した場合、「ドラッグストア」と「近く」というキーワードが含まれているページが検索結果で表示されていました。

しかし、ハミングバード導入後は、検索ユーザーの現在地の近くにあるドラッグストアの情報が記述されたページやそのマップ情報などが、検索結果として表示されるようになりました。

ハミングバードの導入により、音声検索などで使われる会話調の検索クエリの意味を読み取り、それに対応する検索結果を表示することができるようになりました。

これにより、Google検索は、より人間の検索意図を汲み取った検索結果を返すことができるようになり利便性が大きく向上しました。

2014年5月

ペイデイローンアップデート

Payday Loan(ペイデイローン)アップデートは、検索結果の多くがスパムサイトで埋め尽くされているような特定のクエリをターゲットとし、スパムサイトの排除をより強くするアルゴリズムのアップデートです。

アメリカで、payday loanというのは非常に稼げるキーワードであり、広告単価も高くなっているキーワーでした。

その検索クエリから利益を得ようと大量のスパムサイトが生成され、グーグルのガイドラインに違反するブラックハットSEOが蔓延していました。

それに対する規制を強化するために、特にスパムサイトが多い検索クエリに絞って取り締まりを強化したのです。

ペイデイローンアップデートは、ローン、クレジットカード、アダルト、ポルノなどの一部キーワードのコンテンツの品質に関するアップデートなので、それ以外の一般のキーワードにはほとんど影響がありませんでした。

2014年

ピジョンアップデート

ピジョン・アップデート(Pigeon Update)は、海外圏で実施されたGoogleのローカル検索アルゴリズムアップデートです。

ローカル検索と通常検索の結びつきを強めるもので、 ローカル検索結果の品質改善が目的とされました。

ベニスアップデート

ベニスアップデート(Venice Update)は、ユーザーが検索している場所の情報に基づいて、最適な検索結果を表示できるようになったアップデートです。

検索キーワードがローカルエリアと関連すると考えられる場合、検索しているエリアに近い有益な情報が検索結果に表示されるようになりました。

そのため、ユーザーが検索する場所によって検索結果が大きく異なるようになりました。

ピジョンアップデートとベニスアップデートの違い

ピジョンアップデートもベニスアップデートもユーザーの検索する場所によって変化するアルゴリズムですが、ピジョンアップデートは、人によって呼び方が違う地名や名称でも最適化した検索結果を表示するものという点でベニスアップデートとは異なります。

例えば、「USJ」と「ユニバーサルスタジオジャパン」は同じ場所を意味しており、ピジョンアップデートの導入によってどちらのキーワードで検索しても同じよな検索結果が出るようになりました。

2015年2月

モバイルフレンドリーテストを公開

iPhoneやAndroidなどの普及によりスマートフォンなどのモバイル デバイスからウェブへアクセスする数が増加してきました。

Googleはモバイルに対応したWebサイトをそうでないサイトに比べて有利に評価することを発表しました。

ウェブマスターがモバイル対応サイトを制作する手助けとなるように、Webサイトがモバイルフレンドリーがどうかをチェックできるツールを公開しました。

HTTPS/SSLアップデート

セキュリティを高めて検索ユーザーのプライバシーを守るために、Webサイトの常時SSL化を推奨す流ようになりました。

SSL化しているWebサイトをしていないWebサイトよりも有利に扱うことを宣言し、Webマスターにサイトを常時SSL化するように推奨しました。

モバイルアップデート

Googleは全世界でモバイルフレンドリーアップデートを開始しました。

これにより、モバイル版の検索結果では、モバイル フレンドリーなページの掲載順位が引き上げられ、検索ユーザーは、小さなスクリーン上でも読みやすい、高品質で関連性の高い検索結果をより簡単に見つけることができるようになりました。

モバイルフレンドリーなサイトの特徴としては、タップやズームなどをしなくてもテキストが読みやすい、タップターゲットの間隔が適切、再生できないコンテンツが含まれていない、横方向へのスクロールが発生しない、などの特徴があります。

2016年

ポッサムアップデート

ポッサムアップデートは、ローカルランキングフィルターにいくつかの変更を加え、ローカル検索結果がさらに改善されたアップデートです。

ポッサムアップデートにより、ユーザーの位置情報と検索クエリの内容に応じたローカル検索結果が従来よりもさらに多様化しました。

2017年

健康アップデート

健康アップデートは、医療・健康に関連する検索クエリの検索結果において、専門性や権威性がないと思われるサイトの評価を下げるアップデートのことです。

医療・健康に関するクエリだけではなく、YMYL関連のキーワードについても健康アップデートの影響が発生したと考えられています。

YMYLとは「Your Money or Your Life」の略で、お金や生活に関わる人間に生活していく上で、大きな影響を与える可能性のあるキーワードが対象となります。

2018年

スピードアップデート

スピードアップデートは、Webページの表示速度が検索結果のランキングに影響を与えるように改善されたアップデートのことです。

モバイルデバイスからのアクセスが急増したことにより、Webページの表示速度がユーザーのとって重要になりました。

その点を踏まえて、Googleはページの表示速度はランキング要因に組み込み、ユーザーに役立つサイトということでページの表示速度の速いサイトを有利に扱うようになりました。

GoogleはPageSpeed InsightsというWebサイトの表示スピードを計測できるツールを公開しました。

2019年

BERTアップデート

BERTアップデートとは、検索キーワードを個別に理解するのではなく、検索クエリのニュアンスやコンテキスト(文脈)を理解して、より関連性の高い検索結果を返すためのアルゴリズムアップデートです。

BERT(バート)と呼ばれる人工知能(AI)ベースの自然言語処理技術を採用し、自然言語処理の能力を向上させました。

スマホの音声入力技術が進化したことにより、音声入力を使って会話のような検索クエリを使って検索するユーザーが増えてきました。

BERTアップデートにより、「近くの美味しい中華料理屋さんはどこ?」のような会話調の検索クエリに対しても、しっかりと検索意図を汲み取った検索結果を返すことができるようになりました。

2020年

コアアップデート

2020年は1月、5月、12月に3回の大きなコアアップデートが行われました。

いずれのアップデートもE-A-Tの無いサイトが大きく順位を下げました。

- Expertise(専門性があること)

- Authoritativeness (権威があること)

- TrustWorthiness (信頼できること)

E-A-Tを満たしていない事が多い、利益だけを目的としてアフィリエイトサイトなどが大きく順位を下げ、業界に大きな激震が走りました。

December 2020 Core Update

5月に大きく順位を下げたサイトの順位が戻ってくる現象がたくさん見られました。

広告収入を主な目的としているアフィリエイトサイトなども、アフィリエイトサイトということだけを理由に順位が下げられるという傾向が弱まり、純粋にサイトのコンテンツの質が重視されるようなアップデートだったと考えられています。

E-A-Tを満たすために、著者情報の言及や実在性が重視されるようになってきています。